企业级数据处理技术精要

在数字化转型加速的今天,掌握Hadoop框架已成为大数据工程师的必备技能。本课程聚焦实际生产环境需求,通过模块化教学帮助学员构建完整的知识图谱。

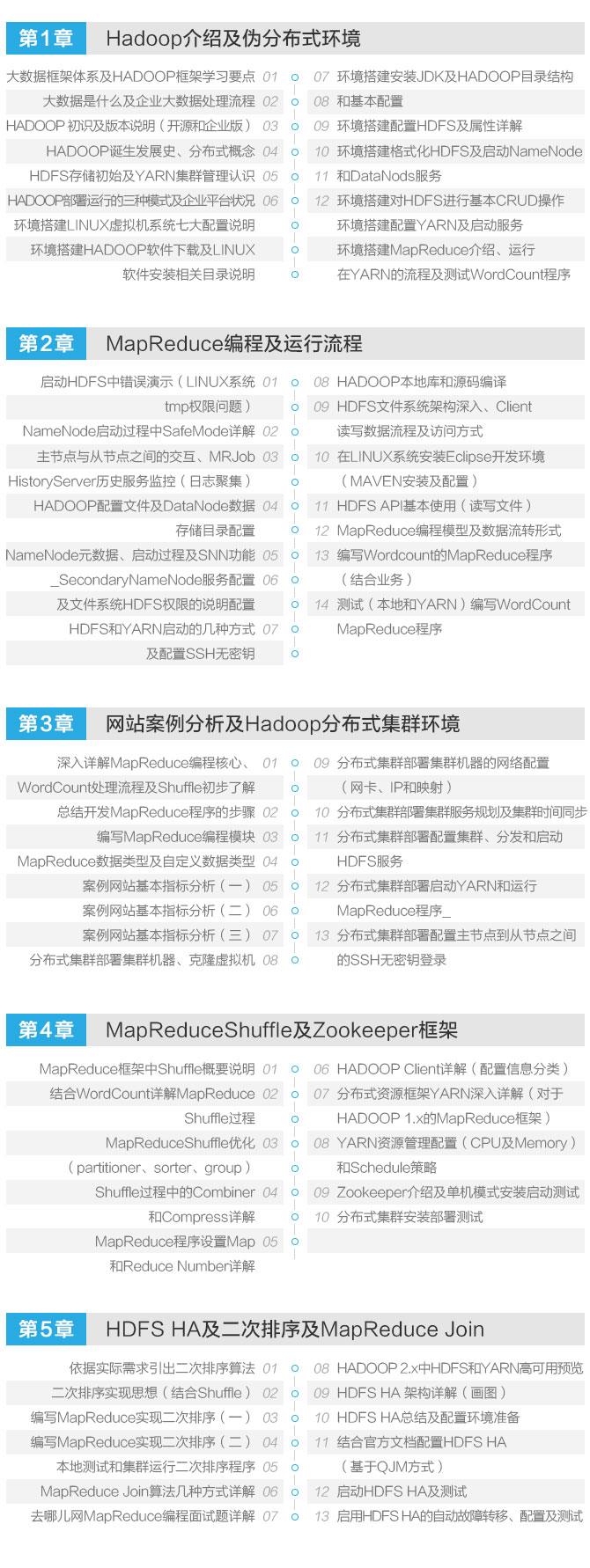

| 教学模块 | 技术要点 | 实操项目 |

| 基础架构解析 | HDFS核心组件 | 集群配置演练 |

| 数据处理实战 | MapReduce编程 | 日志分析案例 |

| 系统优化 | YARN资源管理 | 性能调优实验 |

技术能力提升路径

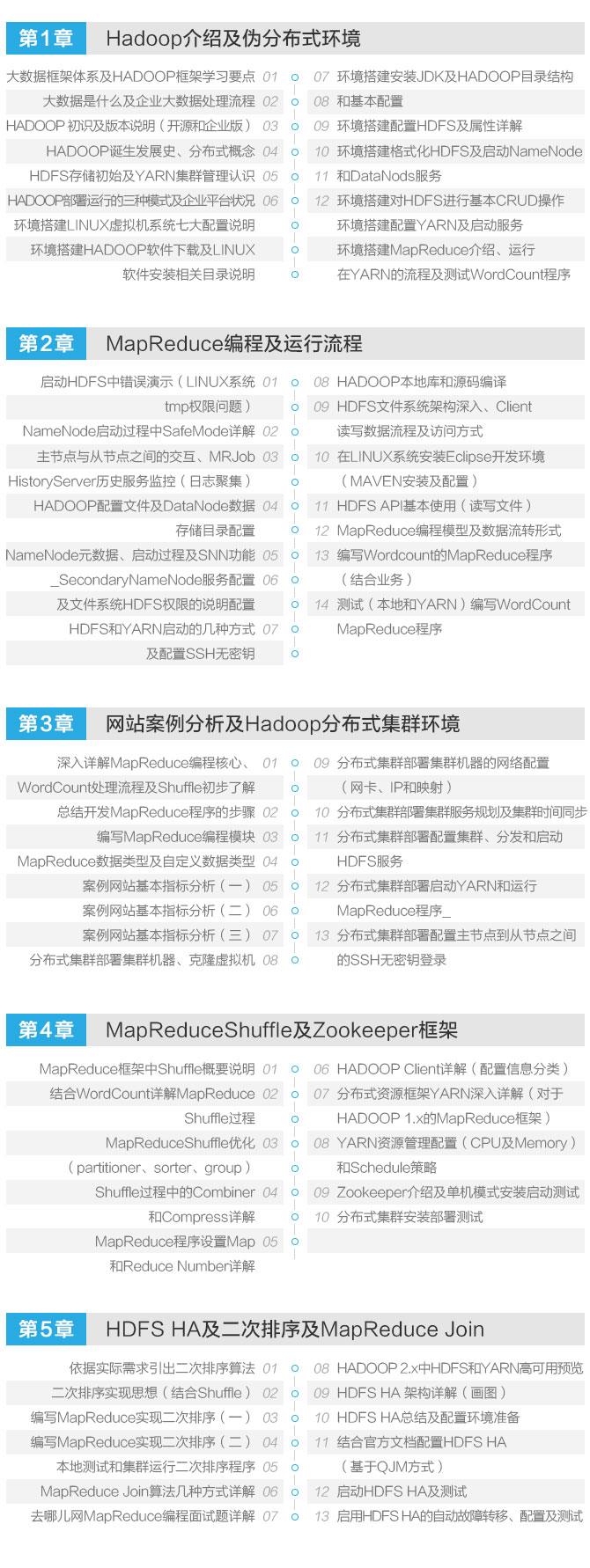

课程重点培养三大核心能力:

- 企业级应用场景解析:通过电商日志分析、金融风控建模等真实案例,理解Hadoop在不同行业的实施策略

- 环境部署专项训练:从单机模式到伪分布式集群搭建,掌握全流程配置技巧

- 数据处理方法论:系统学习数据存储、清洗、分析的标准化操作流程

技术生态深度剖析

课程特别设置Hadoop 2.x新特性专题,详解以下技术演进:

- 高可用性改进:NameNode HA架构设计原理

- 资源管理升级:YARN与MapReduce的协同机制

- 性能优化策略:数据本地化处理优化方案

教学成果保障体系

采用阶梯式能力培养模式:

- 阶段测评:每模块设置实操考核

- 项目答辩:完整项目开发演示

- 技术文档:编写规范的技术实施方案